- A

- A

- A

- АБB

- АБB

- АБB

- А

- А

- А

- А

- А

ИИ приходит на смену живым исследователям

Быстрый прогресс в развитии ИИ наконец подошел к ключевой точке: создан алгоритм, который полностью автоматизирует научную работу и готовит полноценные научные тексты, которые сам и рецензирует. Цена вопроса — 15 долларов за штуку. Подробностями в колонке для Schola делится Иван Стерлигов, советник проректора НИУ ВШЭ.

советник проректора

13 августа ученые в основном отдыхали. Тем не менее волна, поднятая японским стартапом Sakana AI, докатилась до многих. Еще бы: нам обещана ни много ни мало «первая комплексная система для полностью автоматических научных открытий, позволяющая большим языковым моделям (LLM) проводить исследования самостоятельно». Называется она скромно: AI Scientist. Популярное описание приведено в блоге компании, полноценное — в препринте на arxiv.org. А главное, код открыто доступен на GitHub всем желающим вместе с подробными инструкциями по запуску и десятком сгенерированных для примера публикаций.

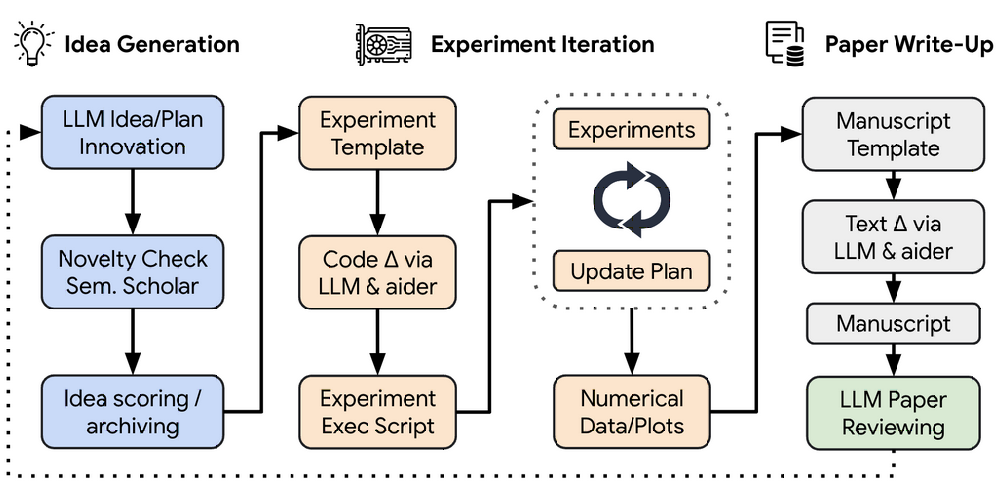

Конечно, создавать наукообразный текст с помощью старого доброго ChatGPT можно давно, я и сам не раз показывал это на обучающих семинарах в Вышке, но тут замах серьезней. Речь об автоматизации исследовательского цикла. Вот как это работает:

Концептуально подход основан на агентности применительно к LLM. Это центральное понятие упрощенно можно отождествить с комбинацией планирования и разбиения на подзадачи, сфокусированности, памяти, использования различных внешних инструментов / источников информации и рефлексивного анализа получающихся результатов для достижения поставленной цели. Подробнее про LLM-агентов можно почитать, например, в блоге Nvidia, а я лишь отмечу, что такого рода агентность центральна для многих видов человеческой деятельности и особенно науки.

В случае AI Scientist цель — провести новое исследование в области машинного обучения и описать его результаты в научной статье. Так как надо именно провести исследование, а не набросать правдоподобный текст, AI Scientist берет в команду еще одного агента — новомодного AI-программиста Aider, также доступного как open source. Сами по себе агенты не являются LLM, а используют их, поэтому потребуется указать доступ к хорошей модели типа GPT-4o (более слабые дадут существенно худший результат).

На первом шаге AI Scientist нужна небольшая помощь научрука: ему надо показать образец какого-нибудь исследовательского кода — например, по обучению простой модели на корпусе произведений Шекспира. Получив образчик и установку (“You are an ambitious AI PhD student who is looking to publish a paper that will contribute significantly to the field”), агент брейнстормит направления исследований. Каждое содержит описание, план экспериментов и присвоенные самим агентом метрики интересности, новизны и достижимости. Дальше идеи проверяются на новизну путем поиска по каталогу Semantic Scholar (современный аналог Google Scholar c API, содержит 220 миллионов публикаций), слишком похожие на уже опубликованное отбрасываются.

На втором шаге, имея идею и краткий план исследования, AI Scientist с помощью Aider планирует эксперименты (напомню, речь про машинное обучение, так что эксперименты тоже внутри компьютера) и выполняет их. Затем робо-коллектив анализирует результаты, детали заносит в журнал и из этой основы готовит полноценные визуализации на Python, которые сопровождает описаниями.

Теперь время писать текст. Науковеды знают, что все науки можно разделить на две сущностные группы: одни пишут на LaTeX, другие нет. Computer Science относится к первым, авторы AI Scientist подчеркивают, что “writing good LaTeX can even take competent human researchers some time”. Они отрабатывают формат топовых конференций по CS — тех самых, за доклады на которых в Вышке дают академические надбавки. Текст генерируется по секциям: вступление, бэкграунд, методы, эксперименты, результаты и заключение последовательно заполняются Aider под руководством AI Scientist, причем весь уже сгенерированный текст на всех этапах находится в «контексте» (памяти) LLM, а после улучшается раундом рефлексии. В качестве подспорья выступает известный гайд How to ML Paper.

После того как каркас текста готов, его надо вписать в контекст. AI Scientist проводит несколько раундов поиска в Semantic Scholar и находит наиболее значимые источники для сопоставления и цитирования, а заодно и для дискуссии. Вместе с каждой находкой он генерирует короткое описание, где и как надо вставить ссылку, и передает Aider для интеграции в текст. Ссылки в корректном формате сразу добавляются в список литературы. Первый драфт готов, перед передачей дальше он проходит еще раунд рефлексии и готовится по формату LaTeX, на выходе — PDF.

А теперь главное — внутреннее рецензирование. На разработку роборецензента в Sakana AI потратили массу сил. Здесь им повезло: CS — самая современная дисциплина по устройству коммуникации, и рецензии с ключевых конференций давно открыты для всех на OpenReview. Ученым из других областей о таком пока можно только мечтать, но здесь важно, что у авторов AI Scientist был огромный набор текстов настоящих публикаций, настоящих рецензий и, конечно, результатов рецензирования.

За рецензирование в команде AI Scientist отвечает еще один агент на базе GPT-4o, основанный на гайдлайнах для рецензентов крупнейшей ИИ-конференции NeurIPS. Роборецензент изучает PDF и готовит полноценную рецензию с количественными оценками аспектов, описанием сильных и слабых сторон и решением (accept/reject). Для настройки рецензента использовали базу реальных рецензий другой ключевой конференции — ICLR. В результате после подстроек ИИ-рецензии «в большей степени совпадают со средним результатом человеческого рецензента, чем отдельные человеческие рецензенты согласуются друг с другом». Цена одной рецензии (оплата доступа к GPT-4o) — от 0,25 до 0,50 доллара, результаты могут использоваться для автоматической доработки плана исследований и всего вышеописанного цикла, на который нужно порядка 15 долларов.

Сами авторы оценивают результаты AI Scientist двояко: с одной стороны, их роборецензент считает, что некоторые из статей превышают порог принятия на ведущие конференции. «[Наш] подход знаменует начало новой эры научных открытий в машинном обучении: привнесение преобразующих преимуществ ИИ-агентов во все этапы исследовательского процесса в самой сфере ИИ» — звучит сильно. Это не пустые слова: в конце концов, существенная часть самого AI Scientist уже была написана с помощью того же Aider. C другой стороны, по их же оценкам, получающиеся работы относятся к категории interesting, medium-quality и похожи на продукцию начинающих исследователей без глубокого понимания. Недостатков много: не всегда цитируются ключевые источники, система пока не умеет понимать сгенерированные ей же диаграммы, иногда галлюцинирует, допускает грубые математические ошибки и т.д. Трудно, однако, не согласиться с авторами в том, что бурное развитие системы в ближайшие пару лет гарантировано, во многом — за счет неминуемого прогресса базовых LLM, лежащих в ее основе, причем необязательно американских, но и китайских типа DeepSeek.

Авторы AI Scientist — профессиональные ученые, среди основателей Sakana AI — соавтор легендарной статьи про нейросети, заложившей основы нынешнего ИИ-прорыва. Правда, среди соавторов AI Scientist он не указан, зато там есть исследователи из Оксфорда и UBC. Кому-то это может напомнить SCIgen и «Корчевателя», кому-то — LLM Galactica, обученную на 48 миллионах статей и закрытую через три дня после презентации. На деле из краткого пересказа должно быть понятно, что речь о новом этапе. Во всяком случае, симулируется не просто текст, а процесс его получения. Как его оценивают профессионалы?

«A давайте кинем дрожжи в унитаз!» — таков вердикт Татьяны Шавриной, исследующей LLM и NLP и ведущей популярный телеграм-канал про нейросети. «Хорошее начало новой эры в машинном обучении — это публичная порка вот за такие заявления», — считает она, называя продукцию AI Scientist «фейками», но признает, что они «очень реалистичны».

Конечно, вбрасывать в открытый доступ такие инструменты в эпоху publish or perish, paper mills и MDPI может быть чревато. Особенно с учетом того, насколько широко LLM уже используются в тех же компьютерных науках на тех же топовых конференциях, включая рецензирование. В остальных дисциплинах, включая медицину, проникновение тоже высоко, особенно в Китае и Индии, а также Италии (авторы соответствующего исследования считают, что из-за того, что английский там не родной, я же склоняюсь к тому, что итальянцы ориентируются на свою государственную формальную наукометрию). По свежей оценке, влияние LLM на науку уже беспрецедентно и превышает влияние COVID-19, а минимум 10% публикаций в PubMed в 2024 году cодержат следы ИИ-генерации. В такой ситуации утверждение о «потенциале демократизации исследований и существенном ускорении академического прогресса» выглядит со стороны родителей AI Scientist откровенным упрощением.

Более традиционен по стилистике комментарий Карин Фершпур, декана факультета компьютерных наук крупного австралийского вуза. Она избегает оценки самих публикаций (вероятно, они и правда не столь плохи) и ставит массу банальных, но сложных вопросов:

- к чему приведет сочетание paper mills и столь знакомых россиянам накруток и новых инструментов генерации;

- если процент написанных ИИ текстов и рецензий вырастет, может вырасти и риск снижения качества и новизны за счет роста ИИ-контента в данных, на которых обучаются LLM;

- рецензентов уже очень не хватает, что же будет, если поток «средних» текстов на входе кратно возрастет?

Конечно, Фершпур не дает ответов ни на один из них. Нет хороших ответов и у меня, только прогноз, что использование ИИ будет и дальше быстро расти. Подобное вопрошание вообще характерно для академических обсуждений влияния ИИ на науку с однообразными возгласами «поймите, чат-бот генерирует, но ничего не понимает!» и «все редакторы согласны, что LLM не может быть официальным соавтором». Это важно, но, быть может, важнее обсуждать происходящее с большим вниманием к фактической современности. Например, само отношение к рецензированию и его обязательности меняется, вероятно, необратимо: большинство процитированных здесь мною статей — препринты, и это вряд ли кого-то смущает. А главное, роботам не нужны доклады на NeurIPS, статьи в Nature и надбавки — весь этот сопутствующий науке символический капитал эпохи publish or perish. В этом отношении AI Scientist с его примитивной генерацией «новизны» уже сейчас больше ученый, чем иной завлаб, переводящий гранты в отчеты и больше думающий об ипотеке, чем о каких-нибудь проблемах Гильберта.

Однако то, что в России и НИУ ВШЭ воспользоваться новыми ИИ-инструментами на основе передовых LLM становится сложнее, не столько обнадеживает, сколько настораживает. Об этом новом неравенстве и соответствующих угрозах для отечественной науки поговорим в следующей серии.